En el artículo anterior vimos cómo construir un agente de IA de atención al cliente con smolagents e InterSystems IRIS, combinando SQL, RAG con búsquedas vectoriales e interoperabilidad.

En ese caso, utilizamos modelos en la nube (OpenAI) para el LLM y los embeddings.

En esta ocasión daremos un paso más: ejecutar el mismo agente, pero con modelos locales gracias a Ollama.

¿Por qué ejecutar modelos en local?

El uso de LLMs en la nube es la opción más sencilla para empezar:

- ✅ Modelos ya optimizados y mantenidos

- ✅ Fácil acceso con una simple API

- ✅ Servicio serverless: no necesitas preocuparte por el hardware ni mantenimiento

- ❌ Costes por uso

- ❌ Dependencia de servicios externos

- ❌ Restricciones de privacidad al enviar datos

En cambio, al correr modelos en local conseguimos:

- ✅ Control total sobre los datos y el entorno

- ✅ Sin costes variables por uso

- ✅ Posibilidad de hacer fine tuning o adaptar modelos con técnicas como LoRA (Low-Rank Adaptation), que permite entrenar algunas capas del modelo para ajustarlo a tu dominio concreto sin necesidad de reentrenarlo entero

- ❌ Mayor consumo de recursos en tu servidor

- ❌ Limitaciones en tamaño/modelos dependiendo del hardware

Ahí es donde entra en juego Ollama.

¿Qué es Ollama?

Ollama es una herramienta que facilita la ejecución de modelos de lenguaje y embeddings en tu propio ordenador con una experiencia muy simple:

- Descargas modelos con un

ollama pull - Los ejecutas de forma local, expuestos como una API HTTP

- Los puedes integrar directamente en tus aplicaciones, igual que harías con OpenAI

En resumen: la misma API que usarías en la nube, pero corriendo en tu portátil o servidor.

Configuración básica de Ollama

Primero, instala Ollama desde su web y verifica que funciona:

ollama --version

Después, descarga un par de modelos:

# Descargar un modelo de embeddings

ollama pull nomic-embed-text:latest

# Descargar un modelo de lenguaje

ollama pull llama3.1:8b

# Ver todos los modelos disponibles

ollama list

Puedes probar embeddings directamente con un curl:

curl http://localhost:11434/api/embeddings -d '{

"model": "nomic-embed-text:latest",

"prompt": "Ollama hace sencillo ejecutar LLMs en local."

}'

Usar Ollama en el agente de IRIS

El repositorio Customer Support Agent Demo incluye ya la configuración para Ollama. Sólo necesitas:

Descargar los modelos necesarios para ejecutarlos en Ollama Yo he utilizado nomic-embed-text para los embeddings de las búsquedas vectoriales y devstral como LLM.

Configurar IRIS para utilizar embeddings de Ollama con el modelo local:

INSERT INTO %Embedding.Config (Name, Configuration, EmbeddingClass, VectorLength, Description)

VALUES ('ollama-nomic-config',

'{"apiBase":"http://host.docker.internal:11434/api/embeddings",

"modelName": "nomic-embed-text:latest"}',

'Embedding.Ollama',

768,

'embedding model in Ollama');

- Ajustar el tamaño de las columnas para almacenar vectores en las tablas del ejemplo (el modelo local tiene un tamaño diferente de vectores que el de OpenAI original).

ALTER TABLE Agent_Data.Products DROP COLUMN Embedding;

ALTER TABLE Agent_Data.Products ADD COLUMN Embedding VECTOR(FLOAT, 768);

ALTER TABLE Agent_Data.DocChunks DROP COLUMN Embedding;

ALTER TABLE Agent_Data.DocChunks ADD COLUMN Embedding VECTOR(FLOAT, 768);

- Configurar el fichero de entorno

.envpara indicar los modelos que queremos utilizar:

OPENAI_MODEL=devstral:24b-small-2505-q4_K_M

OPENAI_API_BASE=http://localhost:11434/v1

EMBEDDING_CONFIG_NAME=ollama-nomic-config

- Actualizar los embeddings

Como tenemos un modelo de embedding diferente del original, debemos actualizar los embeddings utilizando el modelo local nomic-embed-text

python scripts/embed_sql.py

- Ejecutar el agente para que haga uso de la nueva configuración

El código ya utilizará la configuración para que tanto los embeddings como el LLM se sirvan desde el endpoint local.

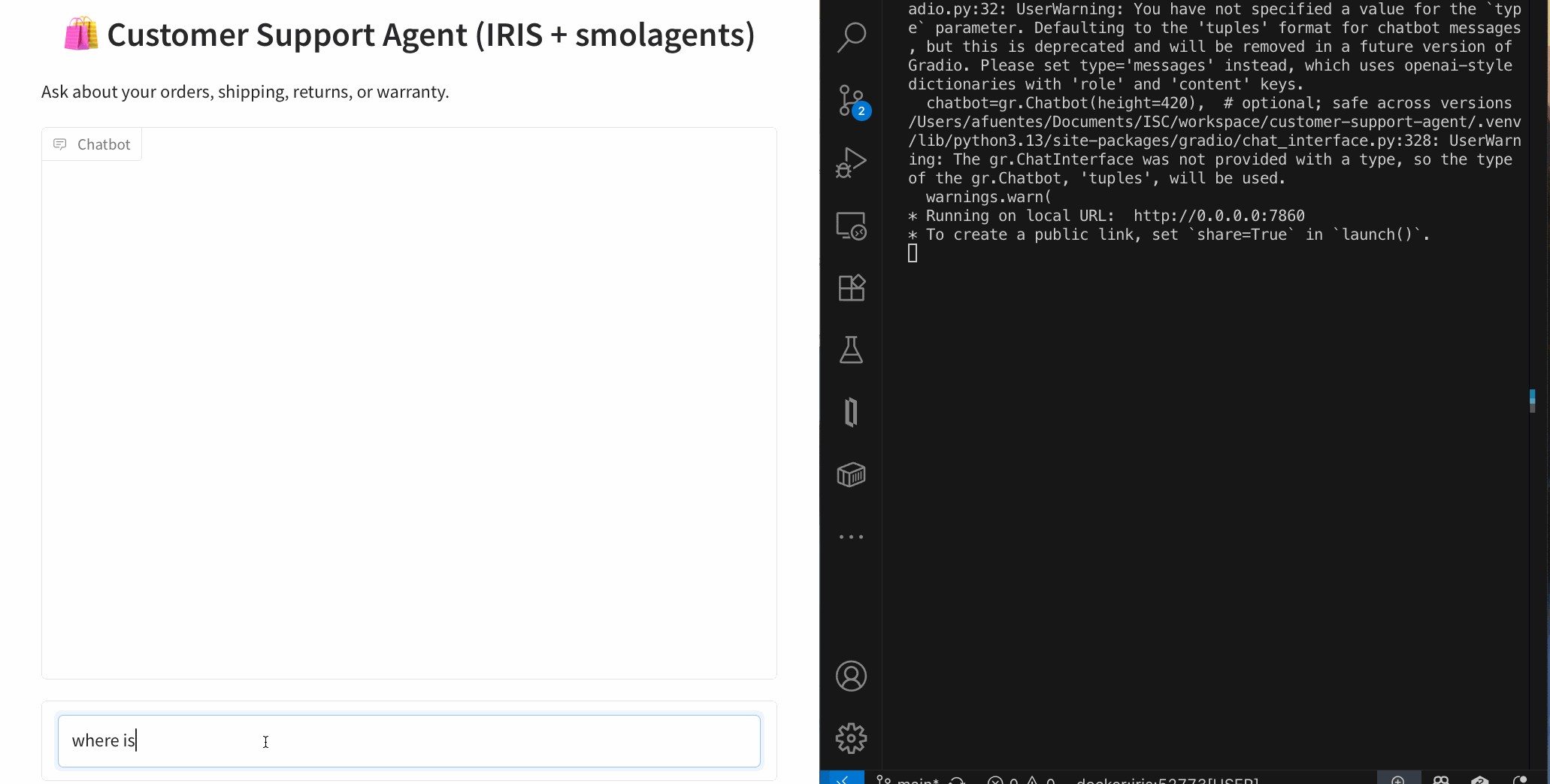

Con esta configuración podrás hacer preguntas como:

- “¿Dónde está mi pedido #1001?”

- “¿Cuál es el plazo de devolución?"

Y el agente utilizará:

- SQL de IRIS para datos estructurados

- Búsquedas vectoriales con embeddings de Ollama (local)

- Interoperabilidad para simular llamadas a APIs externas

- Un LLM local para planificar y generar código que llame a las herramientas necesarias para obtener la respuesta

Conclusión

Gracias a Ollama, podemos ejecutar nuestro Agente de Atención al Cliente con IRIS sin depender de la nube:

- Privacidad y control de los datos

- Coste cero por token

- Flexibilidad total para probar y adaptar modelos (LoRA)

¿El reto? Necesitas una máquina con suficiente memoria y CPU/GPU para correr modelos grandes. Pero para prototipos y pruebas, es una opción muy potente y práctica.

Referencias útiles

📖 Documentación oficial de Ollama: https://ollama.com

📦 Lista de modelos disponibles en Ollama: https://ollama.com/library

🧩 Introducción a LoRA para adaptar modelos grandes de forma eficiente:

- Explicación sencilla: https://huggingface.co/docs/peft/main/en/conceptual_guides/lora